Attention: cette page est obsolète.

Il n'y aura pas de version "bootcamp"

Le programme est passé en v2 depuis Septembre 2024 qui est une version unique du programme avec des lives réguliers.

Pour plus d'informations:

https://www.formations-data.fr/methode_skill_market_fit_accueil

Programme

Data Upskilling

- postuler sereinement à 80% des offres data

- réussir les tests techniques sans stress

- être autonome et compétent une fois en poste

- gagner 1 à 2h par jour en productivité

- pouvoir aider ses collègues...

... sans re-passer des mois à se former ;)

La stack technique que j'ai utilisée en presta/freelance pour des clients comme:

Les formations Data ne préparent pas assez à la réalité du terrain*

*ce n'est pas une fatalité ;)

"J'ai peur de rater mes entretiens technique"

"Je ne sais pas par où commencer / manque d'autonomie"

Mieux encore: on va tout installer nous même from scratch en utilisant les connaissances Linux acquises en partie I du programme

"J'ai peur de ne pas trouver de mission"

Il y a aussi un projet Data pour ajouter du solide à votre CV ;)

"J'ai toujours peur de casser un truc avec git"

Git n'aura plus de secrets pour vous

"Je n'ai pas le temps de me former"

"J'ai l'impression de ne pas être assez compétent"

PS: j'ai recontacté la personne du 2e exemple ci-dessus quelques semaines plus tard: elle a réussi l'entretien ;) )

Programme Data Upskilling

Le programme clef-en-main pour devenir efficace

Tous les participants gagnent en efficacité et en autonomie.

(les témoignages ci-dessous sont tous authentiques et consultables en bas de la page)

La base

1) Maitriser Linux et le Terminal

Pour vous éviter de passer pour un newbie, et vous préparer au cloud ;)

- installation de linux(dual boot / WSL / VM)

- utiliser le terminal efficacement avec bash et vim

- chmod et droits admins

- recherches

- utilitaires: cron & SSH

- Shell like a boss avec "oh-my-zsh"

Indispensable pour TOUS les postes Data

2) SQL Pro'

Pour réussir les interviews et être hyper efficace au jour le jour

- maîtriser les joins à la perfection(y compris cross joins & self joins)

- CTEs

- Agrégations simples et avancées (avec GROUPING SETS & FILTER)

- Windows Functions

- Rank, dense_rank & row_number

- pivot and unpivot

- manipulations (LAG, Coalesce, concat)

- Gestion des dates

Le painpoint principal des Data Scientists

3) Utiliser Git en entreprise

Pour ne plus avoir peur de casser un truc et enfin utiliser toute la puissance du versionning

- à quoi ça sert

- les commandes qu'ils faut absolument maîtriser

- tout se qu'il se passe "sous le capôt" quand vous faites ces commandes

- les principes d'une CI-CD avec les pre-commit hooks

+ les commandes "tips & tricks" pour vous faire gagner beaucoup de temps (et impressionner vos collègues ;) )

Sortir du notebook, créer des APPs et des APIs

4) Python Pro'

Produire du code de qualité professionnelle, créer des apps et des API, communiquer avec des BDD SQL ou des services cloud...et savoir faire à peu près tout ce qu'on pourrait vous demander :)

- utiliser PyCharm comme un pro

- black & mypy (+ utilisation avec git)

- environnements virtuels

- Classes, modules, exception-handling, logging, datetime, json...

- UnitTesting

- Pandas avancé & Polars

- créer une app avec Flask

- créer une app avec Streamlit

- créer et requêter une API avec FASTApi

- communiquer avec SQL: DuckDB, SQLite3...

(On profitera de la création des apps et api pour utiliser git en "situation réelle")

Indispensable pour les Data Engineers

5) Spark

Spark revient dans beaucoup d'offres d'emploi, c'est un indispensable.On va voir à quoi ça sert, et apprendre à s'y retrouver dans la jungle Hadoop, Map Reduce, Hive, Yarn, Spark, etc etc ;)

- Spark, HDFS et YARN: en quoi ils sont liés

- Installer Hadoop en local et apprendre à l'utiliser

- utiliser Pyspark pour ouvrir des fichiers HDFS

- Les API SparkSQL et Data Frames

- Les opérations courantes

- fonctionnement interne de spark: caching, shuffling, partitionning... ( questions souvent posées en entretien)

Le petit + sur votre CV ;)

6) Introduction à Airflow, conclusion et ouverture :)

Un peu de airflow, pour booster votre CV et améliorer les projets perso.

Puis je vous présenterai les étapes suivantes que vous pourrez suivre pour bâtir votre carrière dans la data

BONUS 1

utiliser son IDE comme un pro

190€ -> Offert

BONUS 2

Entretiens avec des professionnels de la data

600€ -> Offert

- J'ai invité 6 pros de la data à présenter leurs parcours

- Ils détaillent les entretiens et les tests techniques qu'ils ont passé

- Et racontent leur quotidien en mission pour que vous soyez préparés à ce qui vous attends ! Spoiler alert: dans la data, nos jobs sont plutôt cool ;)

- (Leurs taux horaires varient entre 100 et 200€, et chaque entretien dure de 1 à 2h. Une heure avec chacun d'entre eux vous aurait coûté au total au moins 600€ ;) )

BONUS 3

La "Checklist du projet parfait"

300€ -> Offert

BONUS 4

Le projet DE End-to-End

500€ -> Offert

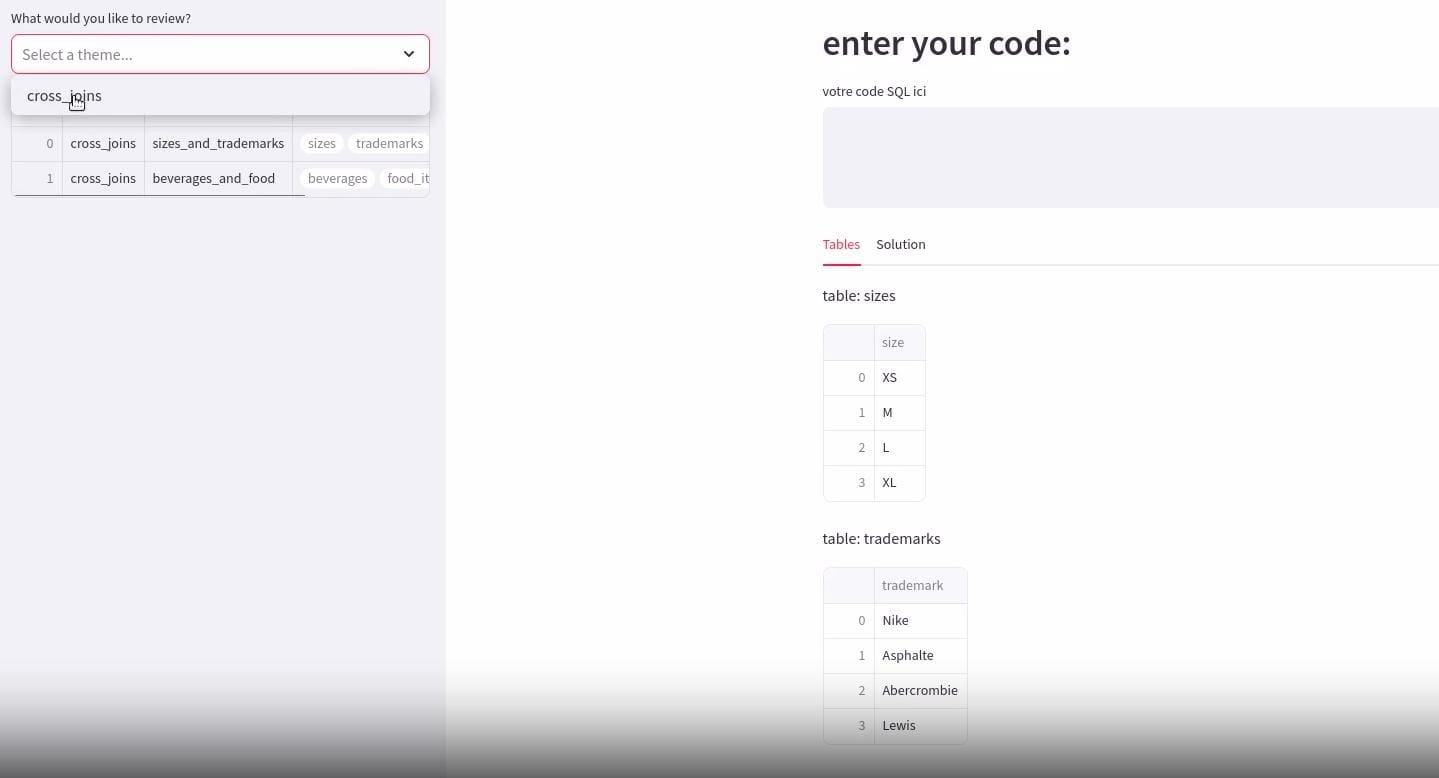

BONUS 5

Une app' de révisions pour le SQL

25€/mois€ -> Offert

- Pour ne pas oublier, il faut pratiquer ! Il y a des sites qui permettent de faire ça, mais ils ne sont pas optimisés pourla progression ni la rétention de l'information : ils présentent les questions dans n'importe quel ordre.

En + ils sont souvent sur un modèle abonnement (il faut payter tous les mois) - Nous, on va créer _ensemble_ (en python) une application de révisions.

Vous verrez comment je crée le projet from scratch et comme vous aurez découvert le code source en live vous pourrez le modifier à votre guise pour ajouter des fonctionnalités.

L'app est donc modulable pour réviser autre chose que du SQL ;) - Quelques participants ont créé des apps hyper complètes avec systèmes d'inscriptions et statistiques détaillées de progression !

BONUS 6

Le groupe Linkedin "Data pros"

75€/mois -> Offert

- Accès à un groupe Linkedin privé pour poser toutes vos questions sur le programme ou la data en général.

- Ce canal a déjà servi à certains participants à se refiler des missions entre eux ;)

- Si vous vous investissez dans le groupe (propositions de missions, entraide sur des sujets tech, etc...), ça peut à terme vous apporter beaucoup plus que la valeur du programme en lui même !

BONUS 7

Data 4 Good :)

Valeur infinie

- 10% des bénéfices reversés à une association d'aide aux sans-abrisJe ferai un post à la fin de l'année avec le montant récolté, l'association récipiendaire et le nombre de nuitées qui seront passées au chaud plutôt que dans la rue.

BONUS "SURPRISE"

Un bonus de la valeur du programme

720€ -> Offert

- La plupart des gens ne terminent pas les formations en ligne qu'ils commencent

- Pour éviter ça, j'ai mis en place un système de rappels emails pour ceux qui ne se sont pas connectés depuis 10 jours

- ET pour vous inciter encore davantage à aller au bout, j'ai "caché" un bonus d'une valeur égale ou supérieure au programme à la fin de celui-ci !